“出逃”的Transformer八子:引领生成式AI革命的谷歌科学家

【编者按】谁也没想到,两位谷歌科学家在走廊中的一次谈话,彻底改变了 AI 行业的行进轨迹。

Transformer,一种在自然语言处理(NLP)等领域展现出强大能力的深度学习模型,在被提出六年后的今天,正在引领此次由 ChatGPT 掀起的生成式 AI 浪潮。

2017 年,“Transformer 八子”发表了题为 “Attention is All You Need” 的重磅论文,其中提出的“自注意力”这一革命性的概念,成为了 Transformer 模型的核心部分。

如今,Transformer 不仅嵌入在谷歌搜索和谷歌翻译中,并且驱动着 ChatGPT 和 Bard 在内的 几乎所有大型语言模型(LLMs)。

另外,Transformer 还支撑着 DALL·E、Midjourney 和 Stable Diffusion 等图像生成工具,GitHub CoPilot 等代码生成器,甚至还包括 DNA 生成模型等。

然而,“Transformer 八子”却因谷歌内部的研究方向和团队结构等种种原因相继选择了离开。日前,最后一位留在谷歌的 Transformer 论文共同作者 Llion Jones 也宣布将于本月底离开老东家。

在离开谷歌后,他们纷纷创建了自己的公司。其中,Polosukhin 创办了一家名为 Near 的初创公司;Gomez 创办了 Cohere;Uszkoreit 创建了一家生物技术公司 Inceptive;Shazeer 与他人共同创办了 Character.ai;Vaswani 和 Parmar 则合作创办了 Essential.ai。

近日,英国《金融时报》(Financial Times)刊登了一篇题为“Transformers: the Google scientists who pioneered an AI revolution”的文章,详细介绍了 Transformers 诞生的过程以及八位作者离开谷歌的原因。

图|从左到右、从上到下依次为:Llion Jones、Niki Parmar、Noam Shazeer、Jakob Uszkoreit、Lukasz Kaiser、Illia Polosukhin、Ashish Vaswani、Aidan Gomez

学术头条在不改变原文大意的情况下,做了简单的编译。完整内容如下:

就像许多科学发现中的突破一样,推动人工智能(AI)革命的那一刻来自于一次偶然的机遇。

2017 年初,当时还任职于 Google research 的科学家 Ashish Vaswani 和 Jakob Uszkoreit 正在谷歌大本营所在地 Mountain View 园区的走廊上讨论一个改进机器翻译的新想法,而该想法后来成为了谷歌翻译背后的 AI 技术。

他们一直与另一名同事 Illia Polosukhin 合作,研究一个他们称之为“自注意力(self-attention)”的概念,这个概念可以极大地加快和增强计算机理解语言的能力。

Polosukhin 是一名科幻迷,他认为“自注意力”有点像刚刚上映的电影《降临》中的外星语言。虚构的外星语言中并不包含线性的词序列,而是使用单一符号来表示一个想法或概念,然后生成整个句子,而人类语言学家必须使用整体符号来解码。

当时最先进的 AI 翻译方法是逐词扫描句子,并按顺序逐个翻译。而“自注意力”的想法是一次性阅读整个句子,分析其所有部分而不仅仅是个别单词。这样可以获得更好的上下文,并且可以并行生成翻译结果。

这三位谷歌科学家推测,这种方法会比当时最好的方法快得多,而且更准确。他们开始在英德(English-German)翻译上尝试一些早期原型,结果发现效果不错。

在走廊里,谷歌资深员工 Noam Shazeer 无意中听到了 Uszkoreit 和 Vaswani 的谈话。Shazeer 在 2000 年便加入了谷歌,当时公司内只有大约 200 名员工。

Shazeer 曾经协助构建谷歌搜索“Did You Mean? ”的拼写检查功能,还参与了其他几项 AI 创新工作,但对现有的语言生成方法感到沮丧,并在寻找新思路。

当他听到“自注意力”的想法时,他决定加入并提供帮助。Shazeer 说:“我支持你们......我们一起来做吧,这将使所有的 AI 研究员受益匪浅。”

这次偶然的谈话促成了 2017 年正式启动的为期数月的合作,最终产生了一种处理语言的架构,也就是“Transformer”。最终,参与其中的八位研究科学家在一篇简短的论文中描述了这种架构,论文标题简洁有力:“Attention Is All You Need”。

其中一位作者 Llion Jones 在威尔士的一个小村庄长大,他说这个标题是向披头士的歌曲《All You Need Is Love》致敬。这篇论文最早发表于 2017 年 6 月,它开启了 AI 的全新时代:生成式 AI 的崛起。

如今,Transformer 在大多数前沿 AI 应用中发挥着支撑作用。它嵌入在谷歌搜索和谷歌翻译中,虽然最初是为这两者而发明的,但它现在还驱动着所有的大型语言模型,包括 ChatGPT 和 Bard 背后的模型。同时,它也驱动着我们手机键盘上的自动完成功能,并为智能音箱提供语音识别服务。

然而,它真正的威力远远超出语言范畴。它可以生成带有重复图案或模式的所有东西,从使用 DALL·E、Midjourney 和 Stable Diffusion 等工具生成的图像,到使用 GitHub CoPilot 等生成器生成的计算机代码,甚至 DNA。

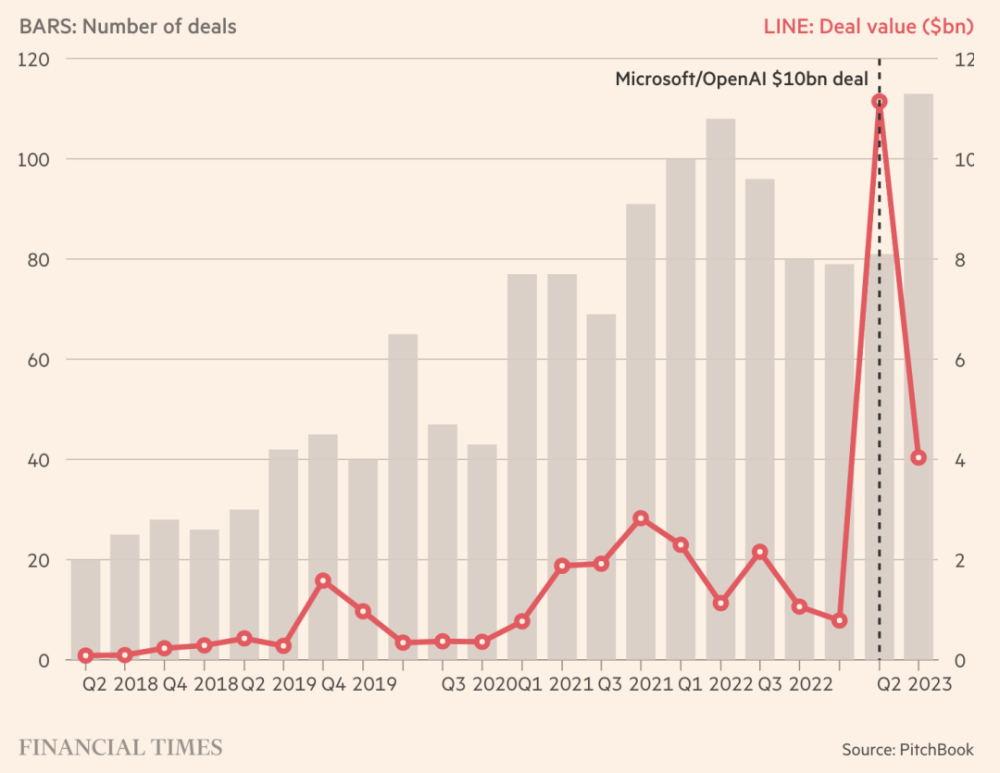

图|有关生成式 AI 的风险投资正在激增(来源:Financial Times)

Vaswani 对音乐有着特别的兴趣,想知道是否可以利用 Transformer 来生成音乐。他惊讶地发现它不仅可以生成古典钢琴音乐,还能生成当时最先进的 AI 模型。

“Transformer 是一种快速捕捉输入的不同部分之间交互的方式,一旦捕捉到,它就可以从中学习特征,”他说。“这是一种通用方法,可以捕捉句子中各个部分之间的交互,或者音乐中的音符,图像中的像素,蛋白质的组成部分。它可以用于任何任务。”

Transformer 的起源以及其创造者的故事有助于解释我们是如何在 AI 领域走到了这一步:这是一个转折点,就像我们在转向互联网或智能手机时那样,它为新一代企业家提供了种子,让他们为大众开发出 AI 驱动的消费产品。

但同时,这也凸显了谷歌在演变为庞大“官僚机构”的过程中究竟如何扼杀了本应蓬勃发展的创业精神以及快速推出新消费产品的能力。我们对八位作者中的七位进行了采访。

这是“创新者困境”(innovator’s dilemma)的鲜明例证,这个术语是由哈佛商学院教授 Clayton Christensen 创造,探讨了行业领导者被小而新的企业超越的原因。尽管谷歌聚集了全球领先的深度学习和 AI 人才,并为他们创造了一个有利的研究环境,但却无法留住他们自己培养的科学家。

谷歌在一份声明中表示,对于 Transformer 和其创造的 AI 生态系统,他们感到“自豪”。他们承认在这样一个充满活力的环境中,有才华的员工可能会选择离开,这是苦乐参半的现实。

专家们认为,这些知识资本的创造导致了创新的爆炸。Alphabet 旗下专注于 AI 投资的成长型基金 CapitalG 的合伙人 Jill Chase 表示:“‘Attention is All You Need ’的成果已经成为几乎所有使用大型语言模型的生成式 AI 公司的基础。我的意思是,它无处不在。这就是其中最疯狂的事情。因为有了 Transformer,这些产品才得以存在。”

创新的诞生

像所有科学进步一样,Transformer 建立在之前几十年的工作基础上,这些工作来自谷歌自身的实验室,以及其子公司 DeepMind(现与 Google Brain 一起合并为 Google DeepMind),Facebook 所有者 Meta,以及来自大学的研究人员等等。

但是在2017年,这些碎片通过谷歌研究部门的几个科学家的偶然集结而得以融合。

最终的团队成员包括 Vaswani、Shazeer、Uszkoreit、Polosukhin 和 Jones,以及当时在多伦多大学攻读学位的实习生 Aidan Gomez 和 Uszkoreit 团队的硕士研究生 Niki Parmar。第八位作者是 Lukasz Kaiser,他也是法国国家科学研究中心的兼职学者。

每个人都被吸引到 AI 研究的新兴领域:自然语言处理。这个团队在教育、职业和地理背景上的多样性使他们独具特色。Uszkoreit 在美国和德国长大,他说:“拥有这样多样化的团队成员对这项工作的发展绝对至关重要。”

Uszkoreit 最初坚决不愿涉足语言理解领域,因为他的父亲是计算语言学的教授。但当他作为实习生来到谷歌时,他发现当时 AI 领域最有趣的问题是语言翻译,尽管这让他感到有些恼火。最后,他不情愿地走上了父亲的道路,也开始专注于机器翻译。

据他们回忆,他们最初以三个独立小组的身份研究“自注意力”的不同方面,但后来决定集中起来。一些团队成员负责编写初始代码、清洗数据和进行测试,而其他人则负责围绕模型创建架构,将其集成到谷歌的基础设施中,以确保其高效运行,并最终使其易于部署。

Jones 谈到,“Transformer 的想法是我们在办公室工作和合作时自然形成的。”谷歌丰富多彩的开放式工作环境,配备园区自行车,后来证明是富有成效的。“我记得 Jakob Uszkoreit 骑着自行车来到我的办公桌前,在我身后的白板上潦草地画了一个模型,然后收集了当时在场同事的想法。”

团队之间的联系源自他们对语言的痴迷,以及利用 AI 来更好地理解语言的动机。正如资深工程师 Shazeer 所说:“文本实际上是我们最集中的抽象思维形式。我一直觉得,如果你想构建真正智能的东西,你应该从文本入手。”

在论文中提到的模型是对原始“自注意力”思想的简化版本。Shazeer 发现,当去除了他们试图添加的所有花哨之后,这种简化的方式效果更好。模型代码提供了起点,但需要进行大量的微调才能使其在图形处理单元(GPU)上运行,而 GPU 是最适合像 Transformer 这样的深度学习技术的硬件。

Uszkoreit 表示,“在深度学习中,一切都不仅仅是方程式本身。关键在于如何将它们应用到硬件上,这是一个巨大的黑魔法技巧的宝库,只有极少数人真正掌握其中的奥秘。”

这些想法主要由 Shazeer 来实现,其中一个共同作者称他为“魔法师”,Transformer 在每一项应用任务中都取得了飞跃式的改进。

它的好处在于它允许计算并行计算,并将它们打包成比其他方法少得多的数学运算,从而使计算速度更快、更高效。Polosukhin 说:“它非常简单,这个模型整体上非常紧凑。”

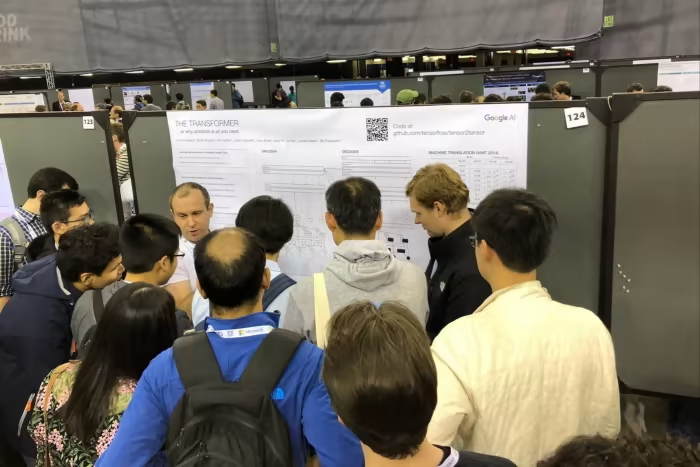

该论文的同行评审版本在 2017 年 12 月发表,恰好赶上了当年在加利福尼亚南部举行的最负盛名的机器学习会议之一——NeurIPS。他们仍然记得,当他们展示工作海报时,他们被会议现场的研究人员团团围住。不久之后,谷歌之外的科学家们也开始将 Transformer 应用于从翻译到 AI 生成答案、图像标注和识别等各个领域中。目前,它在研究论文中的引用次数已经超过 82000 次。

图|Lukasz Kaiser 和 Illia Polosukhin 在 NeurIPS 现场。(来源:Financial Times)

“Transformer 在研究和实际应用中都经历了一次大爆发,”Vaswani 表示,“我们看到它推动了神经机器翻译的发展,语言模型 BERT 出现了,这使得 Transformer 进入了搜索领域——当 Transformer 应用于谷歌搜索时,实用 AI 迎来了一个非常重要的时刻。”

论文发表后,Parmar 发现 Transformer 可以生成类似维基百科的长篇文本,而以前的模型在这方面一直存在困难。她说:“当时我们已经知道,人们以前根本做不到这样的事情。”

Parmar 还认识到了 Transformer 的一个关键特性:当你扩大它们的规模,给它们越来越多的数据时,它们能够学得更好。这为 GPT-4 等大型模型的出现指明了方向,这些模型在推理和语言能力上比它们的“前辈们”要强得多。

“总的来说,Transformer 似乎在任何应用它们的领域里,都比之前的模型表现都好得多,”Jones 说,“我认为这就是滚雪球效应出现的原因。”

“出逃”谷歌

在 Transformer 论文引起强烈的反响之后,研究人员开始对将自己的想法推向市场感到急不可待。

AI 研究的步伐正在加快,特别是在使用 Transformer 生成文本和图像等领域,但许多贡献来自于谷歌之外的创业公司,比如 OpenAI。

七位接受采访的 Transformer 共同作者表示,他们想要发现他们所创造的工具箱能够做什么。“Transformer 之后的几年是研究上最富有成果的几年。很明显,模型会随着更多反馈变得更智能,”Vaswani 说,“没有人能够抗拒这个机会。”

但他们也发现,谷歌的组织结构不允许进行冒险创业或迅速推出新产品。这需要建立一种“新型软件......可以与计算机对话”,Vaswani 补充道,“在谷歌之外实现这一愿景似乎更容易。”最终,他于 2021 年离开了谷歌。

Polosukhin 早在 2017 年就离开了谷歌,创办了一家名为 Near 的初创公司。最初的想法是利用 AI 来教计算机编程,但后来转向了区块链支付领域。

后来,年轻且经验最为不足的 Gomez 也坐不住了。他对时尚和设计充满热情,曾在 Kaiser 的团队实习,并发现自己置身于有关语言理解的令人兴奋的研究前沿。

他说,“我离开谷歌的原因是,实际上我没有看到足够多的产品采用我正在使用的技术。它们没有改变,没有现代化,没有采用这项技术。我没有看到这种大型语言模型技术真正到达它需要到达的地方。”

2019 年,Gomez 离开了谷歌,创办了一家名为 Cohere 的生成式 AI 初创公司。该公司的估值现已超过 20 亿美元,获得了 Nvidia、Oracle、Salesforce 等公司的投资。Gomez 希望将大型语言模型应用于从银行和零售到客户服务的各种商业问题。“对我们来说,重要的是降低使用门槛,”他说,“每个开发者都应该能够使用这些技术来构建应用。”

与此同时,Uszkoreit 决定将 Transformer 应用于一个完全不同的领域。他的初创公司 Inceptive 是一家生物技术公司,正在使用深度学习技术设计“生物软件”。他解释说:“如果你想到计算机软件,它是编程可执行的东西......然后有一个程序,最后转换成可以在计算机上运行的软件。我们想做类似的事情,但是针对的是人体内的细胞。”

该公司已经向一家大型制药公司交付了由 AI 设计的传染病疫苗分子。Uszkoreit 表示,“我相信,这是迄今为止在我过去十年的工作基础上改善甚至拯救人们生命的最佳方式。”

在任职的第二十个年头,Shazeer 于 2021 年离开了谷歌,与他人共同创办了 Character.ai,这是一家允许用户建立属于自己角色聊天机器人的公司。他说:“在大公司推出产品似乎有些困难......而初创公司可以更快地实现。”

Vaswani 和 Parmar 于 2021 年同时离开谷歌,并合作创办了一家名为 Essential.ai 的新公司,该公司致力于在商业领域应用 AI。这家初创公司目前仍处于隐秘状态,但已经从 Thrive Capital 获得了 800 万美元的资金。

“谷歌是一个令人惊叹的地方,但他们希望优化现有的产品......所以事情进展得非常缓慢,”Parmar 说,“我希望利用这项非常有能力的技术构建出新的产品,这是促使我离开的一个很大的动力。”

这些共同作者仍然保持着频繁的沟通,他们共同庆祝彼此的成功,并在成为初创企业家时互相支持,面对独特的挑战。

如果说 Transformer 是一个“大爆炸”时刻,那现在围绕它已经展开了一个宇宙,从几乎预测了所有已知蛋白质结构的 AlphaFold,再到 ChatGPT,Vaswani 称其为“黑天鹅事件”。

这导致了硅谷业内人士称之为“技术过剩”(technology overhang)的时期——即使研究没有取得任何进展,各行业也会花费时间将最新的 AI 技术应用到产品中。

“人们已经感受到了 Transformer 的影响力——AI 吸引了研究人员、技术专家和产品人员。现在,我们相信这种技术已经过剩......在各种产品中有很多价值可以实现,”Vaswani 说,“在某种程度上,这就是我们都分散开,试图将这项技术直接交到人们手中的原因。”