对话邬贺铨院士:我们对AI安全问题认识不够,要用监督学习保障大模型应用安全

出品 | 搜狐科技

作者 | 梁昌均

“AI本身就是双刃剑,但对于其技术的发展以及它带来的安全问题,我们认识还是不够。”在今日开幕的ISC2023第十一届互联网安全大会期间,中国工程院院士、ISC名誉主席邬贺铨对搜狐科技等媒体表示。

他认为,AI大模型的应用,今后会越来越多会渗透到社会、生产、生活方方面面,大模型会无形无影相随。“这既方便了我们的生产生活,但也可能导致我们对它的过度依赖,它的不稳定以及可能产生的安全风险,也会影响到我们的生产生活。”

邬贺铨认为,在AI和大模型的发展存在多个方面的安全风险。比如,国内的数据资源非常丰富,网民数量很多,网上数据量全球最多,但这些数据资源能不能拿来训练是一个问题——很多数据质量无法保证,有些语法不合逻辑,有些是虚假信息,甚至违反道德伦理。

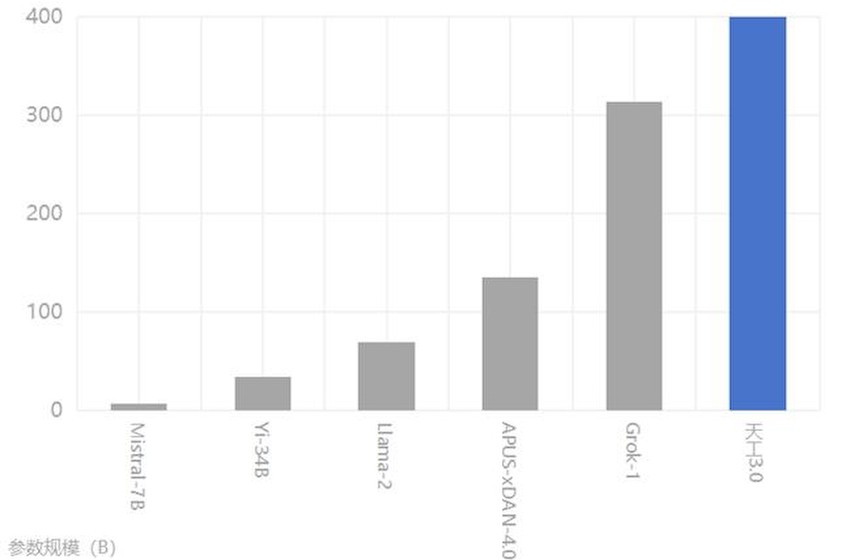

很多中小企业没有自己的模型,如果模型把它们的数据拿到,企业也会担心机密数据泄露。“虽然现在国内都有100多种模型,但这些模型,包括顶级公司开发的模型,是不是能个性化应用到某个行业,仍然存在距离。”邬贺铨说。

同时,邬贺铨提到,现在好像大模型无所不能,但训练过程中的算法和有些推理过程不是人为所能控制,可能会产生一些我们意想不到的结果,可解释性不够,严重的会失控。

此外,境外模型有些是免费的,或者说收费很低,效果也不错,是不是就可以直接拿它来训练?邬贺铨表示,还是要避免过度依赖境外模型,存在一定安全风险,比如对话模型会掌握大众的行为舆情,甚至回复内容会被恶意的利用。

“一方面算法可能失控,另一方面模型可以被人为操纵,那么就导致了不稳定的安全风险。”邬贺铨表示,网信办已就此起草相应的管理办法,对容易引起数据泄露安全的大模型应用,都应该采取比较谨慎的态度。

对于有些模型不进行数据标注,采取无监督学习的方式,邬贺铨也并不认可。“对于某些重要场景的大模型,我还是主张事前做一些数据标注,保证输入语料的质量,还应该保留人工介入微调干预的可能,也就是要监督学习,来保障大模型应用的安全。”

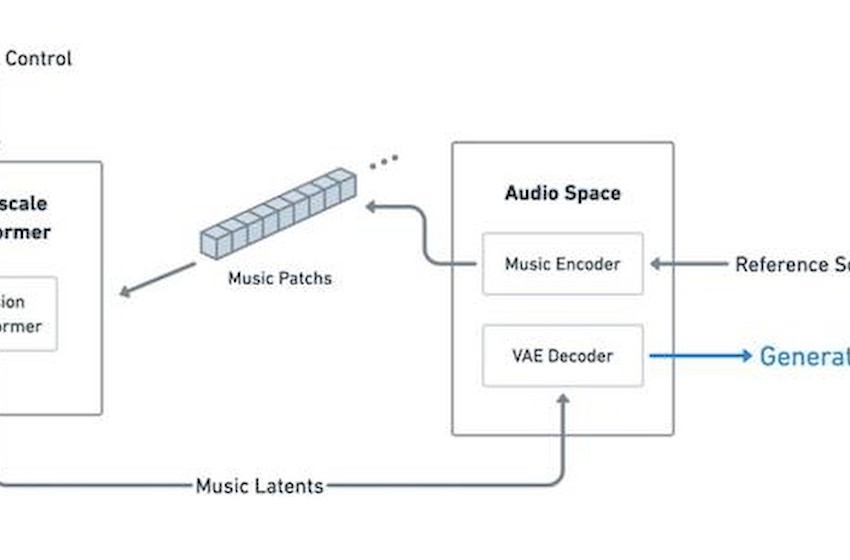

对于AI对数字化的发展,邬贺铨认为,以人工智能为代表的数字技术将重塑数字内容生产方式和消费模式,通用人工智能将实现知识与数据双轮驱动,把智脑加进去,未来单个模型有望通过迁移学习支持多种业务,并且能够精准选择节点,从而有效降低功耗和成本。

“数字安全已经成为数字经济发展的焦点,AI等数字技术的应用本身既是安全防御的重点、手段,也是保障的有力手段,需要将大数据、AI、互联网等技术融合,提升保障能力。”邬贺铨表示,数字安全需要从产业技术管理多个维度保障,还需要人才、法规来支撑。

为此,他也提出多个建议。一是随着数据上升为重要的生产要素,跨境数据流动管理面临巨大的挑战,应该主动迎接IPV6的主导互联网时代,借此提升数据的安全能力,支撑跨境数据流动的有效管理,护航数据安全流动。

二是要摒弃硬件式碎片化弱协同的传统安全防护手段,向云化、服务化的理念升级。数字安全企业需要建立体系化的安全运营服务框架,面向各行各业输出数字安全能力,帮助企业构建安全防御体系,保护数据安全与商业秘密。

三是要完善数字安全的生态系统,要覆盖工业企业设备供应商、基础电信运营商、云服务商、工业互联网平台运营商、工业应用提供商、数字安全提供企业、第三方检测机构与用户等,实现危险威胁处置情报共享。

“数字化将逐渐走向智能化高峰,这也是开启人工智能的时代。”邬贺铨表示,传统安全防护的手段急需升级,数字安全需要探索新的模式,以适应复杂的数字化场景。