可以自我进化的AI,已经在敲人类的门了

作者|腾讯科技 郝博阳

我造我自己

AI威胁的核心:自我进化的速度

关于AI可能带来的威胁在过去几个月的时间中已经让人有点疲惫了。从业界大佬马斯克、山姆奥特曼,到学术界巨擘杰弗里·辛顿,约书亚·本亚吉都多次表达了对AI威胁的强烈恐惧。但同时,以杨立昆为代表的很多AI的研究人员和从业者都对此威胁不屑一顾,认为这不过是一种科幻式的夸张。

两种观点争议的核心在于:我们是否有可能控制AI和对它的应用。如果在人工智能超越人类智能时我们还是找不到合理的和它对齐,对它限制的方法的话,那它就很可能会陷入失控。

乐观主义者们认为当下的AI离完善的AGI还尚有不小的距离,远没有达到超过人类的智能水平。因此在发展AI的期间我们完全可以通过寻找人工干预对齐的方法,控制AI发展的方向。另外,因为现阶段训练AI必须通过人的参与才能完成,因此人类可以随时停止它。

然而对悲观主义者而言,也许我们已经没有这个时间了。过去几年来AI的发展突飞猛进,作为深度学习之父的辛顿都多次表达被震惊之感。他告诉《纽约时报》:“看看五年前和现在的情况。这种前进的速度这太可怕了。”

但这还不是最快,因为AI还面对着一些速度瓶颈。其中最要命的就是无法靠算力加速的人工对齐工作。但如果有一天,它能突破人工参与这个限制会发生什么呢?一个完全可以自我进化的AI。

对此,MetaLab的 Tamlyn Hunt 曾在《科学美国人》上撰文称:人工智能算法将很快达到快速自我完善的地步。这威胁到我们控制它们的能力,并对人类构成巨大的潜在风险。提出暂停AI实验建议的Tagesmark也在之前参与Lex的播客时,表达了同样的观点:如果这一自我完善能够被做到,AI进化的速度将大幅加快,而且也会基本完全脱离人类的控制。

按照他们的观点,一旦AI跨过自我进化的速度这个门槛,那些乐观主义的论点也就不再有效。AI加速进化,失控就在眼前。

那可以自我进化的AI到底离我们还有多远?现在看来已经近在咫尺了。

自我进化的AI,已经徘徊在门前

在当前的AI训练中,为什么人工是不可缺少的?

完成一个大语言模型需要经过三个阶段:预训练、提示微调和强化学习。前两个阶段目前可以完全依靠给定的数据集由AI自行完成。但如果想要AI的回答准确更可理解,更符合特定需求,还需要一个重要的步骤——即来自人类反馈强化学习(RLHF)。在这一过程中,人类标记员与预训练的模型对话,提供对话样本让模型生成一些回复。之后标记员会对回复选项打分排名。最后把这个结果反馈回模型中,以强化它的奖惩算法。这也是GPT4和ChatGPT相对于GPT3最重要的一个策略升级,通过RLHF,OpenAI很大地提升了给模型的回应质量和能力。

这个RLHF,也就是强化学习的步骤就是之前在主流大语言模型训练过程中还无法被AI自主接管的唯一步骤。

为什么说之前,因为现在AI也能做到了。

AI研究者表示:完了

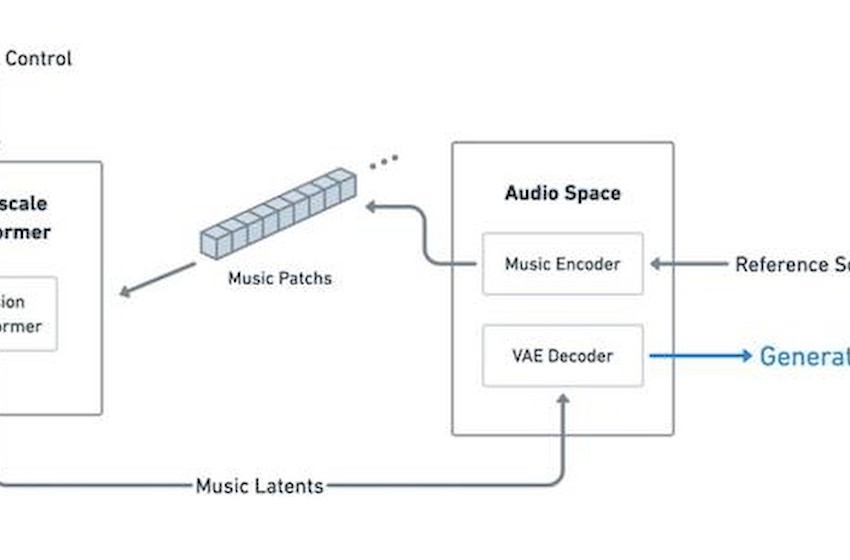

在Google的新论文“RLAIF:Scaling Reinforcement Learning from Human Feedback with AI Feedback”测试了一种革命性的新技术,使AI系统能够通过使用其他AI的反馈来递归地改进自己。

这种新技术被称为RLAIF(AI反馈强化学习)。它并非本文作者独创,而是在之前被其Anthropic的研究者提出的一个概念(Gilardi et al., 2023; Ding et al., 2023). Bai et al. (2022b)。他们用这RLAIF 和 RLHF 结合形成一个综合的Constitutional AI,用于融合人类和AI提出的偏好应用在微调上,为微调提效。但这一工作并没有直接比较AI的反馈和人类反馈的效果。本文作者这一次就单独让AI作为反馈强化的唯一参与者,测试其效果。

作者限制了一个相对较窄的使用场景:用强化学习来训练人工智能系统的文本摘要能力——即产生从较长文章中捕捉关键点,来进行简明摘要。具体实验如下:

给定一个经过监督微调(SFT)的大语言模型(在本实验中是OpenAI开源的Reddit TL;DR数据集进行的预训练)。RLHF的处理流程是:

1. 让被训练的语言模型都为给定的文章生成文本摘要

2. 人类标注师对比较并评估几对总结,判断哪一个总结更优秀

3. 这些人类的偏好被用来开发一个“奖励模型”,预测人类会喜欢哪些总结

4. 然后,这个奖励模型被用来提供反馈和奖励,以增强人工智能代理生成被人类认为优秀的摘要

这一标注操作会进行多轮,以有效改进这个语言模型的效果。

RLAIF系统经历了相同的整体过程。然而关键的区别在于,这里面作为裁判的一个能力更强经过提前训练的“现成”自然语言模型。作者用经过精调后的PaLM-2.7B 来提供反馈判断,形成一套完整地对语言模型输出打分的偏好系统。这个先进的人工智能系统的反馈被用来代替人工评分,以训练提供训练奖励的奖励模型。

基本框架完全一致

训练这个用作偏好打分的LLM的过程也相当简单明了,完全通过提示(prompting)完成。共四步:

1. 情况简述:介绍并描述当前的任务

2. 小样本给予(可选步骤):给出一个文本事例,几组总结的结果,一个可用的理性思维链和一个偏好判断

3. 需注释内容的范例:一个文本和一组总结

4. 结论:一个对LLM的提示终止线(比如说:偏好的总结=XX)

三步走的方法

在用两种方法完成一轮强化学习训练后,人类标记员对这两个训练完成模型的总结能力进行了评价。其结论是RLAIF策略与RLHF策略效果相当。经RLAIF训练过的模型总结的结果在 71%的情况下超过了SFT基线的预训练模型的结果,而经RLHF训练过的模型在73%的情况下超过了基础与训练模型(其中2%差异可以认为没有统计学意义)。单纯比较经过强化学习的结果语言模型,RLAIF对RLHF的胜率各为50%。这就意味着纯粹使用AI反馈进行微调的RLAIF系统在强化学习方面,和人类反馈能达到一样的效果。

两种方法的评分比较

作者之后把研究更推进了一步。既然大语言模型已经在很多标准测试中取得了比一般人更好的成绩,针对这种有着某种标准的偏好反馈任务,有没有可能优化RLAIF的水平,让它们甚至可能超过人类标注员的水平呢?完全有可能。

一个方向是加强提示工程。作者初步试验了使用不同的提示词技术优化RLAIF给出的判断。其中包扩一些提示策略、思维链推理和自我一致性。最终发现无上下文示例提示+思想链的效果最好。而用自我一致性要求和较多上下文示例去加强思维链反而有可能会降低AI的训练能力。这表明随着研究人员的不断尝试,RLAIF的性能仍有很大地提升空间。

0-Shot最好

除了提示工程上的改进,模型本身的能力也会影响最终的标注水平。作者接下里还对RLAIF系统进行了改变计算规模的实验。以及观察注释经验提升对判断准确的影响。好不意外,他们发现较大的模型在RLAIF训练后产生更高质量的反馈,从而导致更好的最终总结性能。然而经验对效果提升的影响是比较有限的,在RLAIF进行过数千个带注释的摘要比较后,它带来的准确性收益开始递减。当然这表明模型本身可能已经获得了充分地反馈,形成了稳定标准。

目前看来,这种方法也并非完全没有缺点。在定性分析后,作者发现RLAIF生成的模型连贯性略低于RLHF,但它不太容易产生幻觉。

目前AI发展速度的瓶颈,都有了突破的解决办法

论文的内容就这么多。但我们可以考虑的未来却更丰富。随着越来越多的在AI性能提升和训练领域中AI开始逐渐替代人类的角色。在很近切的未来,我们就很可能看到计算机模型以越来越复杂和快速的方式相互建立和增强,达到远远超出孤立状态下的智能水平。

尽管RLAIF确实需要大量的计算资源来进行自动反馈,但在初始训练后,它消除了持续的人类参与的需要。RLAIF方法有着不言而喻的优点,即提供训练反馈的系统可以快速标记大量的经验,远远超出人类的注释范围。

RLAIF的成功提供了一个即将到来的机器学习范式转变的一瞥,即依靠AI系统增强自身的范式已经有了充分的基础。人工智能中的递归自我完善,自我实现在可能在一年前看还是一个长期的愿景,但现在已经越来越触手可及。

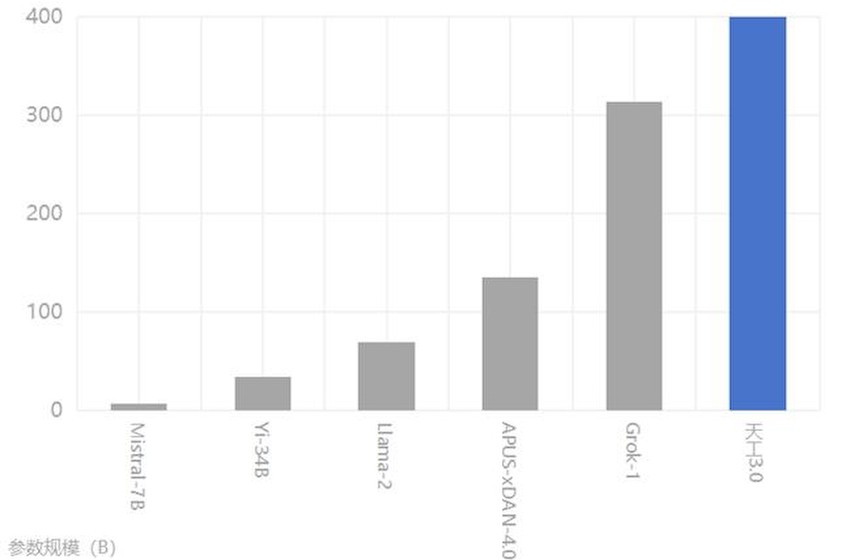

随着人工智能的能力越来越强,进一步提高其智能水平遇到了三个核心瓶颈:数据,算力以及人工调整的效率。

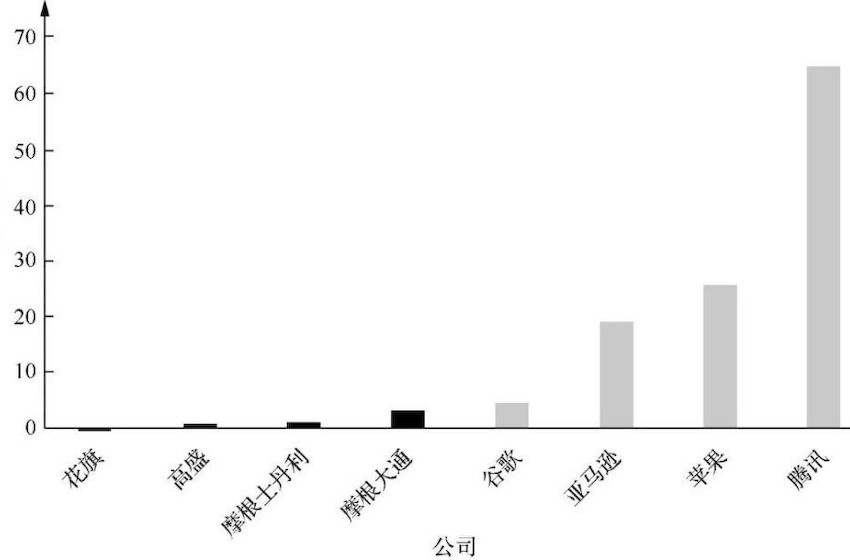

算力瓶颈的问题并非是真实的天花板,更多是面对AI的突然爆发,整体硬件产业的一种措手不及。随着产能的迅速调整,老黄豪言2024H100供货200万块。更别提在更多新玩家入局(比如最近憋着要在GPU市场上与英伟达争雄的AMD,自己打着自研小算盘的亚马逊和谷歌,以及数十家GPU初创公司)和更大的算力基建铺设之后,这个瓶颈就会逐步自然得到解除。

老黄:AI的命脉(H100)就抓在我手里

数据方面的瓶颈主要来源于人类生产高质量的内容数据目前已经大部分被AI训练所消耗,在没有新的数据补充的情况下,缩放效应带来的语言模型能力的线性成长就无法达成。但这个问题其实已经被一定程度的解决了。早在7月,微软、OpenAI和Cohere等公司就已经开始测试使用合成数据(计算机生成的信息)训练大语言模型。虽然剑桥牛津的学者发表论文警告说随着时间的推移,这些合成数据或许会破坏模型,导致「不可逆转的缺陷」。但至少在一些实验条件下,比如港大利用合成图像训练模型的实验中,这一通路还是获得了很好的效果的。

在RAILF出现之前,训练AI的最大瓶颈坑就是人工调整对齐的效率难以提升。比如在GPT4的开发过程中,完成预训练的时间可能仅有3个月左右,但使用RLHF进行对抗和强化的过程就持续了6个月。超过训练模型时间的两倍,而且训练模型的时间可以通过算力加强和算法改进缩短,但人工的有效速度很难提升。现在论文中的RAILF一但被有效应用,这一瓶颈自然也就解决了。

AI进化上的路障,已经一个接一个的被扫清。我们控制它的方法改进却似乎远没有这么快。