为什么说我们对AI大模型的工作原理知之甚少?

人工智能语言模型不是人类,但我们使用律师资格考试或美国医学执照考试之类的测试来评估它们,就好像它们是人类一样。

模型在这些考试中往往表现得很好,可能是因为模型的训练数据中有大量此类考试的例子。正如我的同事威尔·道格拉斯·海文(Will Douglas Heaven)在他最近的一篇文章中所写的那样,“有些人被它们展现出的‘人类’智慧所迷惑,另一些人则一点也不相信。”

(来源:AI 生成)

越来越多的专家呼吁,不要用这些测试来评估人工智能模型,理由是这种行为助长了人工智能的炒作,并造成了“人工智能语言模型的水平比实际水平更高的错觉”。

在威尔的故事中,让我印象深刻的是:我们对人工智能语言模型是如何工作的,以及它们为什么会生成特定的结果知之甚少。利用这些测试,我们试图根据它们的输出来衡量和美化它们的“智能”,但却没有完全了解它们究竟是如何运作的。

作者简介:梅丽莎·海基莱(Melissa Heikkilä)是《麻省理工科技评论》的资深记者,她着重报道人工智能及其如何改变我们的社会。此前,她曾在 POLITICO 撰写有关人工智能政策和政治的文章。她还曾在《经济学人》工作,并曾担任新闻主播。

支持:Ren

免责声明:凡本网站发布的文章、图片、音频、视频等内容所表述的观点和立场不代表本网站的观点和立场,若对该观点或立场有疑义或异议,请及时用电子邮件或电话通知我们,以迅速采取适当措施,避免给双方造成不必要的经济损失。凡本网站发布的所有文章 、图片、音频、视频文件等资料的版权归版权所有人所有,本站采用的非本站原创文章及图片等内容无法一一和版权者联系,如果本网所选内容的文章作者及编辑认为其作品不宜上网供大家浏览,或不应无偿使用,请及时用电子邮件或电话通知我们,以迅速采取适当措施,避免给双方造成不必要的经济损失。

相关阅读

只是偶然搜索,天工AI竟然走心回答,勾起魔兽催泪回忆杀!

2024.04.30

盘不完,根本盘不完……怎么没人早点告诉我AI音乐这么好玩

2024.04.25

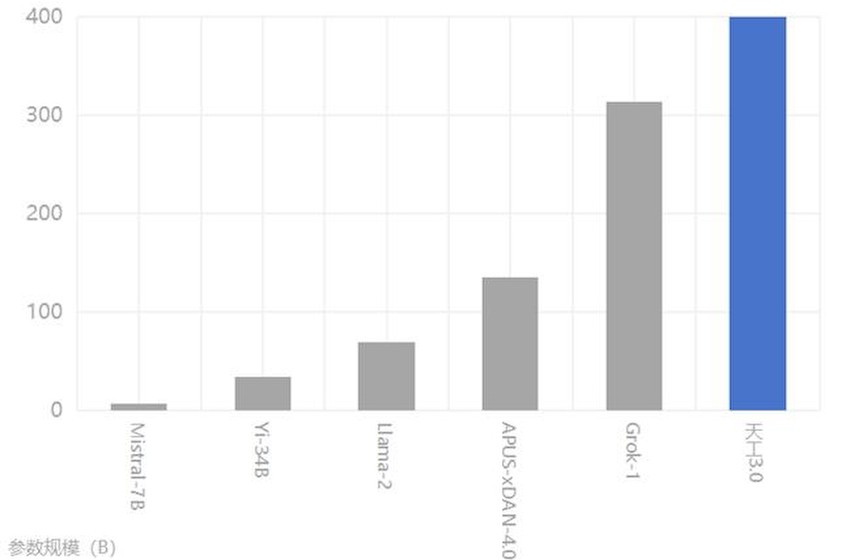

中国首个音乐SOTA模型「天工音乐大模型」今日公测

2024.04.17

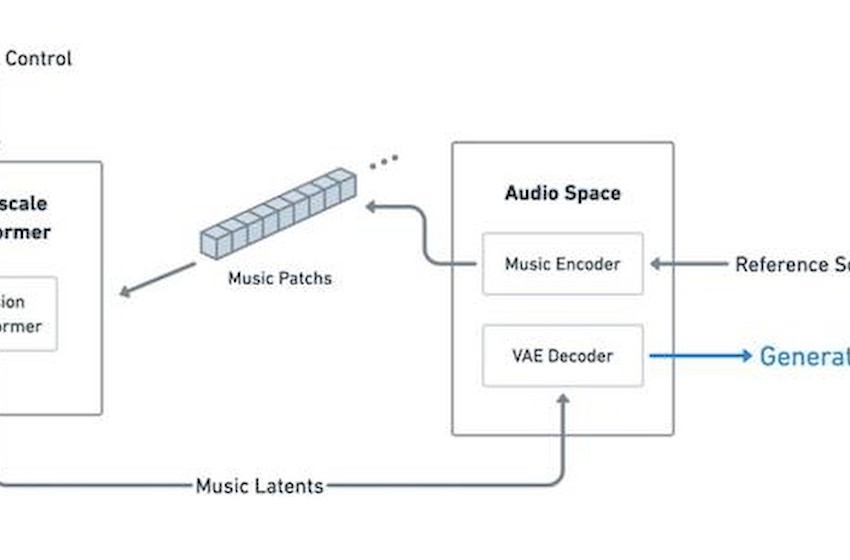

解码「天工SkyMusic」,填补AI音乐领域技术空白

2024.04.12

「天工SkyMusic」跨界喜剧,用实验音乐探索笑声与旋律的碰撞

2024.04.11